/Co to Edge Computing?

Rozwój technologii edge computingu zrewolucjonizował sposób myślenia o przetwarzaniu i przechowywaniu danych. Wraz z rosnącym zapotrzebowaniem na szybszy i bardziej efektywny dostęp do danych i aplikacji, edge computing pojawił się jako swego rodzaju wybawca. W tym artykule zbadamy koncepcję tej technologii w kontekście serwerów, w tym jej definicję, historię i zastosowania. Omówimy również cechy, zalety i wady tego rozwiązania w serwerach oraz najnowsze trendy i technologie w tej dziedzinie.

Czym jest edge computing?

Edge computing to model przetwarzania rozproszonego, który przybliża przetwarzanie i przechowywanie danych do miejsca, w którym są one potrzebne, w celu zmniejszenia opóźnień i zwiększenia wydajności. Ta koncepcja została po raz pierwszy wprowadzona w 2014 roku i od tego czasu zyskała popularność ze względu na rozwój Internetu rzeczy (IoT) i potrzebę przetwarzania danych w czasie rzeczywistym.

Historia edge computingu

Jego początków można doszukiwać się w koncepcji przetwarzania rozproszonego, która sięga lat 70. XX wieku. Jednak specyficzny termin „edge computing” został ukuty w 2014 roku przez firmę Cisco, która dostrzegła potrzebę nowego modelu obliczeniowego do obsługi rosnącej liczby urządzeń IoT.

Jak działa edge computing?

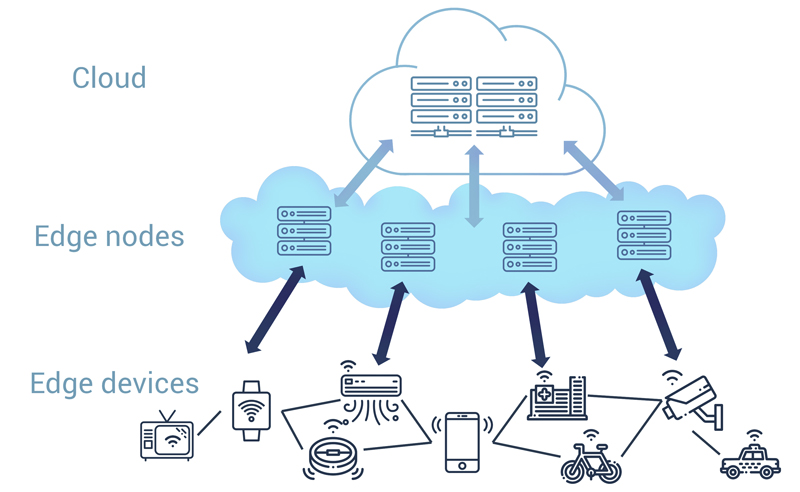

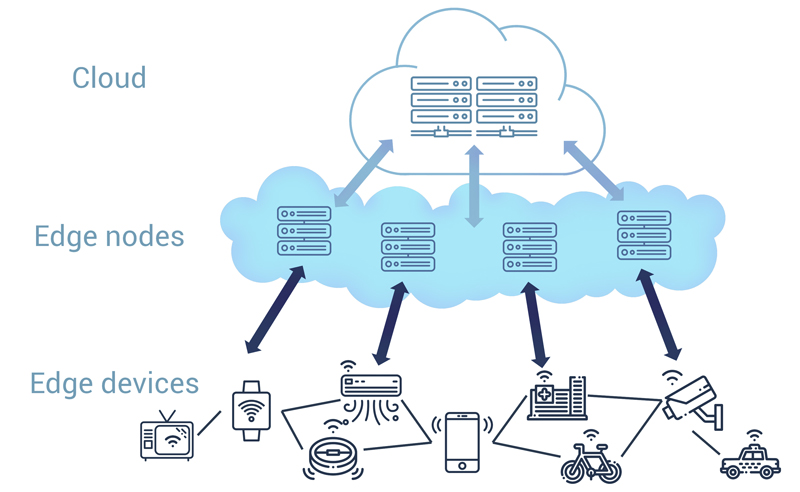

Edge computing polega na wdrażaniu małych komputerów o niskiej mocy, znanych jako urządzenia brzegowe, na brzegu sieci, bliżej miejsca, w którym generowane są dane. Te urządzenia brzegowe przetwarzają i przechowują dane lokalnie, a do chmury wysyłają tylko najbardziej istotne dane do dalszego przetwarzania i przechowywania. Zmniejsza to ilość danych, które muszą być wysłane do chmury, a tym samym zmniejsza opóźnienia i poprawia czas reakcji.

Edge computing w kontekście serwerów

Edge computing jest coraz częściej stosowany w serwerach, szczególnie w kontekście brzegowych centrów danych. Edge data centers to mniejsze centra danych, które są zlokalizowane bliżej użytkowników końcowych, aby zapewnić szybszy dostęp do danych i aplikacji. Wdrażając serwery brzegowe w tych miejscach, przedsiębiorstwa mogą poprawić wydajność swoich aplikacji i zmniejszyć opóźnienia.

Cechy edge computingu w serwerach

Edge computing w serwerach oferuje szereg kluczowych cech, w tym:

- Niskie opóźnienia – przetwarzając dane lokalnie, serwery brzegowe mogą zapewnić użytkownikom odpowiedzi w czasie rzeczywistym.

- Skalowalność – serwery brzegowe mogą być łatwo skalowane w górę lub w dół w zależności od potrzeb, co pozwala firmom szybko reagować na zmiany popytu.

- Bezpieczeństwo – przetwarzając dane lokalnie, edge computing pomóc w poprawie bezpieczeństwa danych i prywatności, ponieważ wrażliwe dane nie muszą być przesyłane przez sieć.

- Efektywność kosztowa – poprzez zmniejszenie ilości danych, które muszą być wysyłane do chmury, edge computing może pomóc w zmniejszeniu kosztów przechowywania i przetwarzania danych w chmurze.

Zalety edge computingu w serwerach

Edge computing w serwerach oferuje szereg korzyści dla przedsiębiorstw, w tym:

- Poprawa wydajności – poprzez zmniejszenie opóźnień i poprawę czasu reakcji, edge computing może pomóc firmom w dostarczaniu szybszych i bardziej responsywnych aplikacji.

- Zwiększona niezawodność – przetwarzając dane lokalnie, serwery brzegowe mogą pomóc zapewnić, że aplikacje pozostaną operacyjne nawet w przypadku utraty łączności z chmurą.

- Większa elastyczność – wdrażając serwery brzegowe, firmy mogą wybrać przetwarzanie danych lokalnie lub w chmurze, w zależności od konkretnych potrzeb.

- Zwiększone bezpieczeństwo – przetwarzając dane lokalnie, edge computing może przyczynić się do poprawy bezpieczeństwa i prywatności danych.

Wady edge computingu w serwerach

Chociaż edge computing w serwerach oferuje wiele korzyści, istnieją również pewne potencjalne wady, które należy rozważyć. Należą do nich:

- Zwiększona złożoność – wdrażanie serwerów brzegowych wymaga starannego planowania i zarządzania, a także może zwiększyć złożoność całej infrastruktury IT.

- Wyższe koszty – wprowadzanie edge computingu może być droższe niż poleganie wyłącznie na infrastrukturze chmury, ze względu na konieczność zakupu i utrzymania dodatkowego sprzętu.

- Ograniczona moc przetwarzania – serwery brzegowe mogą mieć ograniczoną moc przetwarzania w porównaniu z serwerami w chmurze, co może wpłynąć na ich zdolność do obsługi dużych ilości danych.

Podsumowanie

Edge computing to potężna technologia, która może pomóc przedsiębiorstwom w zwiększeniu wydajności, niezawodności i bezpieczeństwa ich aplikacji. Wdrażając serwery brzegowe, firmy mogą korzystać z zalet przetwarzania brzegowego, a jednocześnie wykorzystywać skalowalność i efektywność kosztową chmury obliczeniowej. Ważne jest jednak, aby dokładnie rozważyć potencjalne zalety i wady przetwarzania brzegowego przed podjęciem decyzji o jego wprowadzeniu.