/NVIDIA H100 – Rewolucyjny akcelerator graficzny dla obliczeń o wysokiej wydajności

NVIDIA, wiodący producent procesorów graficznych (GPU), zaprezentował NVIDIA h100, rewolucyjny akcelerator GPU przeznaczony do wysokowydajnych obliczeń (HPC). Ten przełomowy akcelerator został zaprojektowany tak, by sprostać wymaganiom najbardziej wymagających obciążeń w dziedzinach sztucznej inteligencji (AI), uczenia maszynowego (ML), analizy danych i innych.

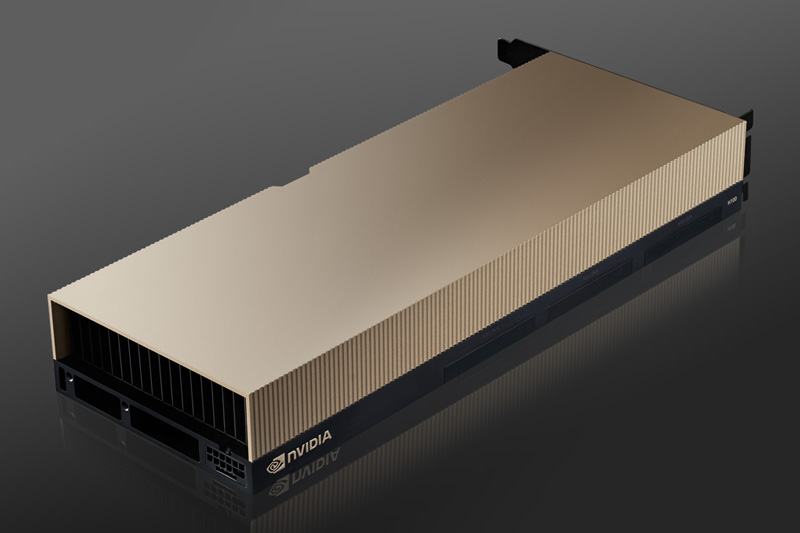

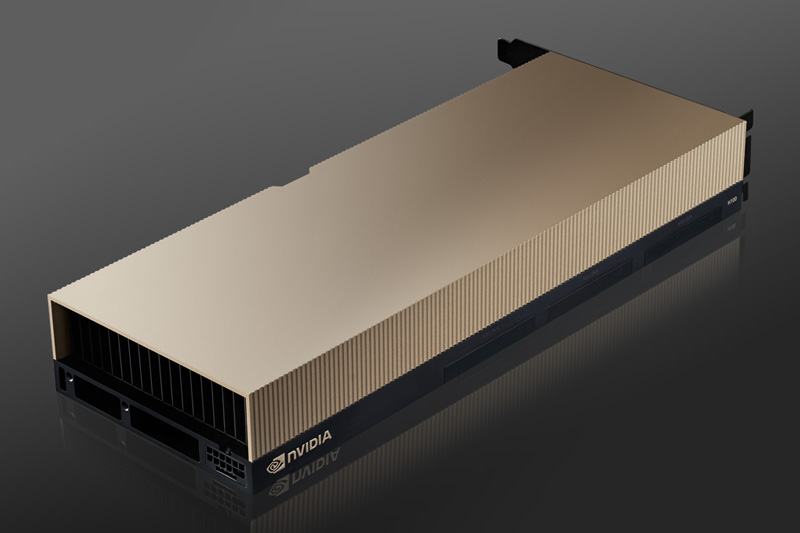

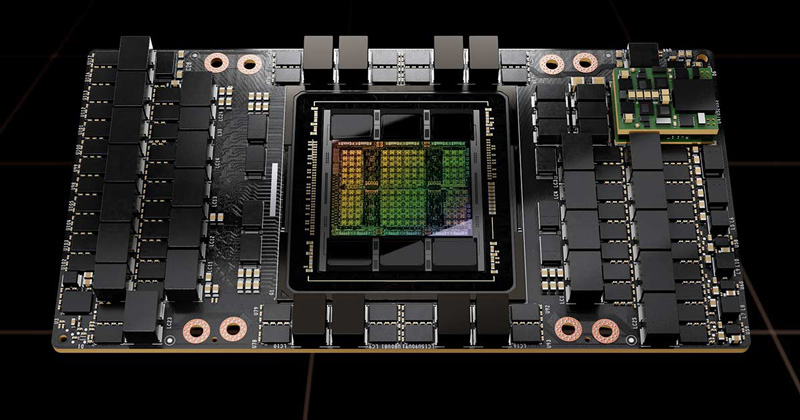

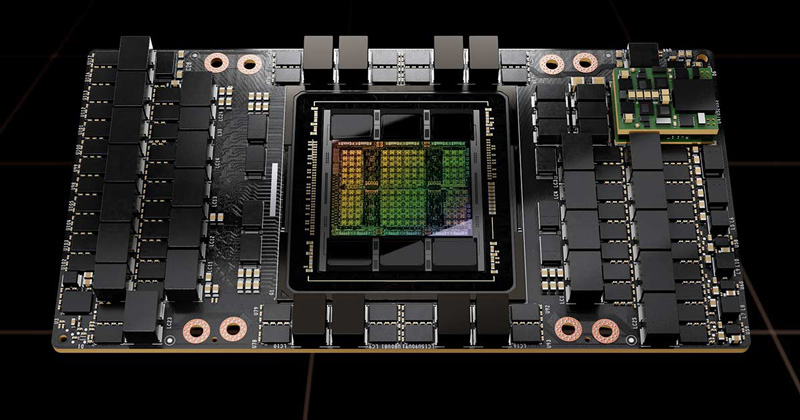

Budowa

NVIDIA h100 to potężny akcelerator GPU, który oparty jest na architekturze Ampere firmy NVIDIA. Zaprojektowany został z myślą o zapewnieniu niezrównanej wydajności dla obciążeń HPC i może obsługiwać szeroki zakres aplikacji, od głębokiego uczenia po symulacje naukowe. h100 zbudowany jest na procesorze graficznym NVIDIA A100 Tensor Core, który jest jednym z najpotężniejszych procesorów graficznych dostępnych obecnie na rynku.

Cechy

NVIDIA h100 wyposażony jest w kilka funkcji, które wyróżniają go spośród innych akceleratorów GPU dostępnych na rynku. Niektóre z najbardziej godnych uwagi cech to:

- Wysoka wydajność – NVIDIA h100 został zaprojektowany, aby zapewnić najwyższy poziom wydajności dla obciążeń HPC. Wyposażony jest w 640 rdzeni Tensor, które oferują do 1,6 teraflopsów wydajności w trybie podwójnej precyzji i do 3,2 teraflopsów wydajności w trybie pojedynczej precyzji.

- Przepustowość pamięci – H100 posiada 320 GB/s przepustowości pamięci, co pozwala mu na łatwą obsługę dużych zbiorów danych i złożonych obliczeń.

- NVLink – H100 obsługuje również technologię NVLink firmy NVIDIA, która umożliwia współpracę wielu procesorów graficznych jako pojedynczej jednostki. Umożliwia to szybszy transfer danych i przetwarzanie pomiędzy procesorami graficznymi, co może znacząco zwiększyć wydajność w obciążeniach HPC.

- Skalowalność – NVIDIA h100 jest wysoce skalowalna i może być wykorzystywana w wielu różnych aplikacjach HPC. Może być wdrażany zarówno w środowiskach lokalnych, jak i w chmurze, co czyni go elastycznym rozwiązaniem dla organizacji każdej wielkości.

Porównanie

Porównując NVIDIA h100 do innych akceleratorów GPU na rynku, należy wziąć pod uwagę kilka kluczowych różnic. Oto krótkie porównanie pomiędzy akceleratorem NVIDIA h100 a niektórymi z jego czołowych konkurentów:

- NVIDIA H100 vs. NVIDIA A100 – NVIDIA H100 zbudowana jest na tej samej architekturze co A100, ale posiada dwukrotnie większą przepustowość pamięci i jest zoptymalizowana pod kątem obciążeń HPC.

- NVIDIA H100 kontra AMD Instinct MI100 – H100 przewyższa MI100 pod względem wydajności pojedynczej precyzji, przepustowości pamięci i efektywności energetycznej.

- NVIDIA H100 kontra Intel Xe-HP – H100 został zaprojektowany specjalnie dla obciążeń HPC, podczas gdy Xe-HP jest bardziej wszechstronny i może być użyty w szerszym zakresie aplikacji.

Podsumowanie

Ogólnie rzecz biorąc, NVIDIA h100 to potężny i wszechstronny akcelerator GPU, który został zaprojektowany z myślą o obciążeniach związanych z obliczeniami o wysokiej wydajności. Jego wysoka wydajność, przepustowość pamięci i obsługa NVLink sprawiają, że jest to doskonały wybór dla organizacji wymagających najwyższej mocy obliczeniowej. W porównaniu z najlepszymi konkurentami, h100 wyróżnia się optymalizacją i skalowalnością HPC, co czyni go doskonałym wyborem dla organizacji każdej wielkości.